Более 1500 исследователей из разных областей объединились, чтобы открыто отвергнуть использование технологий для прогнозирования преступности, утверждая, что они будут воспроизводить несправедливость и причинять реальный вред.

Коалиция за критические технологии написала открытое письмо Springer Verlag в Германии, чтобы выразить свою серьезную озабоченность по поводу недавно разработанного автоматизированного программного обеспечения для распознавания лиц, разработанного группой ученых из Гаррисбургского университета, штат Пенсильвания.

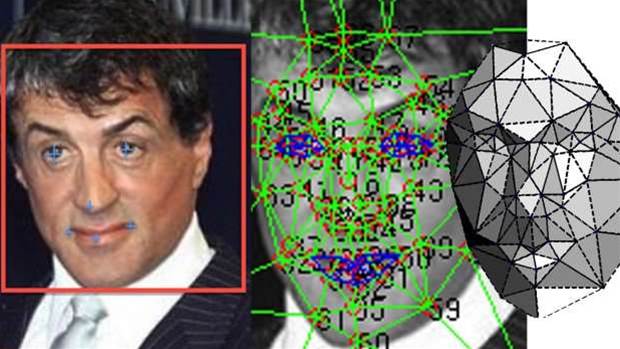

Исследования природы серия книг издательства Springer намерен опубликовать статью ученых Гаррисберг имени Глубокая Нейросетевая Модель для прогнозирования преступности с использованием обработки Изображений.

Коалиция хочет, чтобы публикация этого исследования — и других в том же духе — была отменена, утверждая, что в статье содержатся утверждения, основанные на необоснованных научных предпосылках, исследованиях и методах.

Разработанное ветераном Департамента полиции Нью-Йорка и аспирантом Джонатаном Корном вместе с профессорами Натаниэлем Эшби и Рузбехом Садегяном, программное обеспечение исследователей Гаррисбергского университета утверждает 80-процентную точность и отсутствие расовых предубеждений.

По мнению исследователей Гаррисбергского университета, автоматизированная технология распознавания лиц уменьшает скрытые предубеждения и эмоциональные реакции для целей предупреждения преступности, правоохранительных органов и военного применения.

«Программное обеспечение может предсказать, является ли кто-то преступником, основываясь только на фотографии его лица», — заявили исследователи Гаррисбергского университета.

Автоматизированные системы, которые просеивают человеческие популяции в поисках людей, которые, вероятно, совершат преступление в будущем, и задерживают и наказывают их до того, как они совершат незаконную деятельность, были предсказаны авторами Джорджем Оруэллом и Филиппом К Диком в 1940-х и 1950-х годах.

Технология прогнозирования преступности была популяризирована в фильме «Отчет меньшинства» 2002 года, основанном на одноименном рассказе Дика.

С ускорением освоения все более способных и мощных нейронных сетей для машинного обучения и искусственного интеллекта теперь возможны так называемые системы «до преступления».

Однако, несмотря на обещание менее предвзятого предупреждения преступности с помощью машинного обучения, основанного на практике, утверждающей, что она справедлива, беспристрастна, подотчетна и прозрачна, коалиция ученых забила тревогу, утверждая, что технология-это что угодно, но только не технология.

«Давайте проясним: нет никакого способа разработать систему, которая могла бы предсказать или идентифицировать “преступность”, которая не была бы расово предвзятой — потому что сама категория “преступность” является расово предвзятой», — заявила коалиция ученых.

Данные, генерируемые системой уголовного правосудия, не могут быть использованы для «идентификации преступников» или прогнозирования их поведения, поскольку они лишены контекста и причинно-следственной связи и могут быть в корне неверно истолкованы, утверждали они.

Кроме того, как показали бесчисленные исследования, правовая система на каждом этапе обращается с цветными людьми более жестко, чем с белыми в той же ситуации.

Эта врожденная предвзятость в системе правосудия вызывает серьезные искажения в данных, заявила коалиция ученых.

Существует недостаточная подготовка и стимулы для ученых, занимающихся машинным обучением, чтобы приобрести навыки, необходимые для понимания культурной логики и неявных предположений, лежащих в основе их моделей, что привело к кризису валидности ИИ.

Менее двух лет назад Amazon была вынуждена прекратить использование секретного механизма рекрутинга ИИ после того, как специалисты по машинному обучению обнаружили, что этот алгоритм не нравится женщинам, и вместо него выбрали кандидатов-мужчин.

Коалиция заявила, что машинное обучение должно выйти за рамки компьютерных наук.

Игнорирование врожденных и порой непреднамеренных предубеждений, встроенных в машинное обучение, рискует привести к разработке технологии предупреждения преступности, которая воспроизводит несправедливость и наносит реальный вред, добавили ученые.